Page 328 - 《软件学报》2025年第12期

P. 328

钱忠胜 等: 结合时间间隔数据增强的对偶视图自监督会话推荐模型 5709

⑧ SparseEnNet 可生成鲁棒的增强项目来缓解推荐中的数据稀疏性问题, 并搭建一个自训练增强学习模块,

用于捕获相似序列间的一致性关系. 相较于 SparseEnNet 模型, 本文模型在 HR@N 和 NDCG@N 指标上分别最少

提升 4.93%, 3.39%.

这些方法虽然在一定程度上提升了推荐效率, 但无法捕捉到多对多的会话间隐藏高阶关系, 且均采用单一的

对比学习方式, 模型的泛化能力不足, 很难适应不同领域的推荐任务. 本文模型 TIDA-DSSR 构建了对偶视图编码

器, 在不同视角下进行两种对比学习, 在充分挖掘会话间多对多的高阶关系的同时, 提升了模型的泛化能力, 使模

型在各个数据集上相较于对比模型均有最优的表现.

综上分析, 相比于其他模型, 本文模型 TIDA-DSSR 在 Beauty, Sports, Home 和 Yelp 上的性能均有较大幅度的

提升, 整体平均提升达 5.93%. 本文模型在不同数据集上的表现差异, 既体现了时间间隔数据增强策略的有效性, 也

揭示了其在泛化能力方面存在一定的优化空间. 在 Beauty 数据集上, 模型表现显著优于其他模型, 平均提升

11.14%; 在 Sports 和 Home 数据集上分别平均提升 5.03% 和 5.26%. 这些领域的特点是商品品牌集中度较高、属

性相似性较强, 用户会话中往往蕴含更多隐藏的高阶关系. 模型通过时间间隔数据增强与对偶视图编码器的结合,

能更好地捕捉这些特性, 充分挖掘会话间的隐藏关系. 然而, Yelp 数据集中的用户行为受到更多外部因素 (如地理

位置、社交推荐) 的影响, 时间间隔对用户偏好的表达能力相对较弱, 但本文模型在此数据集上仍能平均提升

2.28%. 为应对不同类型数据对时间间隔敏感性的差异, 本文提出的模型通过自适应调整机制优化时间间隔增强策

略, 以适应不同数据集特性. 具体而言, 模型可在训练过程中动态评估时间间隔对推荐性能的贡献, 通过调节时间间

隔数据增强模块的权重, 自动适配到不同领域的数据分布. 例如, 在商品属性高度相似的场景 (如 Beauty 数据集),

模型会增强对时间间隔的利用, 以充分挖掘会话内及会话间的高阶关系; 而在属性分布较分散或受外部因素影响较

大的场景 (如 Yelp 数据集), 模型则会降低时间间隔的权重, 同时更加注重融合更多上下文特征. 通过这种自适应的

时间间隔权重调整, 所提模型 TIDA-DSSR 不仅可保持在多数数据集上的高性能, 还能在多样化场景下展现出更强

的泛化能力. 另外, 从指标值的角度上看: HR 值与 NDCG 值分别平均提升 5.96% 和 5.89%. 这是因为本文模型构建

了更合理的多视角自监督任务框架来提高模型的泛化能力, 并改善因数据增强早期可能带来的无关项目的干扰.

4.4.2 消融实验 (RQ2)

为验证时间间隔数据增强、对偶视图编码、原始会话对比学习这 3 个构件对推荐性能的影响, 构建了 5 种变

体模型, 将本文模型 TIDA-DSSR 与它们进行对比, 以证明各构件存在的必要性. 其中, ① Ours-1 不考虑时间信息

对会话的数据增强, 而是用原始会话进行编码. 将该变体模型作为对比, 主要考察本文模型的时间间隔数据增强模

块的作用; ② Ours-2 仅用 Transformer 编码器进行编码, 不考虑对偶视图编码对会话间信息的挖掘影响. 将该变体

模型进行对比, 主要阐明本文模型的对偶视图编码模块的作用; ③ Ours-3 去除了以原始会话编码作为对比学习任

务信号的构件, 直接使用数据增强后的会话进行对比学习. 将该变体模型作为对比, 主要验证本文模型的原始会话

对比学习模块的合理性; ④ Ours-4 仅保留数据增强模块, 不使用对偶视图编码器进行编码, 也不加入原始会话对

比学习. 将该变体模型作为对比, 主要说明本文模型的数据增强模块与其他构件组合的效果如何; ⑤ Ours-5 仅保

留对偶视图编码模块, 不实施数据增强, 也不加入原始会话对比学习. 将该变体模型作为对比, 主要阐述对偶视图

编码模块与其他构件组合的有效性. 而对于仅保留原始会话对比学习构件这种变体模型无需讨论, 因为仅依靠该

构件无法完成自监督任务. 各模型的构件描述情况如表 5 所示.

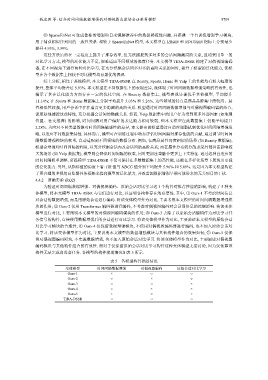

表 5 各模型构件描述情况

变体模型 时间间隔数据增强 对偶视图编码 原始会话对比学习

Ours-1 × ○ ○

Ours-2 ○ × ○

Ours-3 ○ ○ ×

Ours-4 ○ × ×

Ours-5 × ○ ×

TIDA-DSSR ○ ○ ○