Page 284 - 《软件学报》2025年第12期

P. 284

杨建喜 等: 多语义视图驱动的 OWL 知识图谱表示学习方法 5665

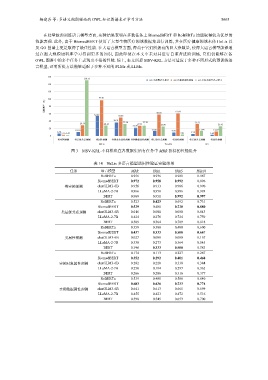

在轻量级预训练语言模型方面, 实验结果表明在多数任务上 BiomedBERT 和 RoBERTa 均能取得较为优异的

性能表现. 此外, 由于 BiomedBERT 使用了大量生物医疗领域数据集进行训练, 其在医疗健康领域本体 HeLis 以

及 GO 图谱上更是取得了最佳性能. 在大语言模型方面, 得益于它们所拥有的巨大参数量, 使得大语言模型能够通

过在超大规模语料库学习得到更多的知识, 因此即使在本文中未对其进行自监督进阶训练, 它们仍能够在各

OWL 图谱中的多个任务上表现出不俗的性能. 综上, 本文所提 MSV-KRL 方法可适应于多种不同形式的预训练语

言模型, 证明所提方法能够适配于多种不同的 PLMs 或 LLMs.

160

150.73

w/o 多视图语义划分 w/o 自监督进阶训练 w/o 多任务联合表示学习

140

120

97.01

100

性能提升 (%) 80

60 58.26 61.64

54.09

50.28

40 36.41 32.34 27.78

29.19 28.16 27.51 32.53 26.43

22.79 25.91

20

10.65 13.86 9.59 13.99 12.27

6.48 5.73

2.10 2.43 3.81 3.69

0

类实例预测 类层级关系预测 类属性预测 实例对象属性预测 实例数据属性预测 类层级关系预测 类属性预测 类层级关系预测 类属性预测

HeLis FoodOn GO

图 3 MSV-KRL 不同模块在各数据集所有任务中 MRR 指标的性能提升

表 14 HeLis 多语言模型适用性验证实验结果

任务 语言模型 MRR H@1 H@5 H@10

RoBERTa 0.956 0.936 0.981 0.987

BiomedBERT 0.972 0.958 0.992 0.996

类实例预测 chatGLM3-6B 0.956 0.933 0.986 0.990

LLaMA-2-7B 0.966 0.950 0.986 0.993

BERT 0.969 0.951 0.992 0.997

RoBERTa 0.523 0.423 0.692 0.731

BiomedBERT 0.529 0.400 0.720 0.880

类层级关系预测 chatGLM3-6B 0.016 0.000 0.000 0.043

LLaMA-2-7B 0.424 0.276 0.724 0.759

BERT 0.509 0.364 0.709 0.818

RoBERTa 0.359 0.300 0.400 0.600

BiomedBERT 0.437 0.333 0.500 0.667

类属性预测 chatGLM3-6B 0.027 0.000 0.000 0.167

LLaMA-2-7B 0.338 0.273 0.364 0.545

BERT 0.396 0.333 0.500 0.583

RoBERTa 0.174 0.113 0.227 0.287

BiomedBERT 0.352 0.292 0.401 0.468

实例对象属性预测 chatGLM3-6B 0.282 0.220 0.338 0.384

LLaMA-2-7B 0.250 0.194 0.297 0.362

BERT 0.266 0.206 0.316 0.377

RoBERTa 0.539 0.488 0.586 0.640

BiomedBERT 0.683 0.636 0.733 0.774

实例数据属性预测 chatGLM3-6B 0.641 0.613 0.665 0.699

LLaMA-2-7B 0.455 0.423 0.472 0.516

BERT 0.598 0.545 0.653 0.700