Page 343 - 《软件学报》2025年第9期

P. 343

4254 软件学报 2025 年第 36 卷第 9 期

投毒更新并上传缩放后的投毒更新到服务器, 从而破坏全局模型. Zhang 等人 [15] 提出了一种防御方法 RobustFL,

该方法通过在服务器端建立一个基于 logits 的预测模型来决策给定的预测模型属于哪个参与者, 并以对抗训练的

方式避免该预测行为, 以缓解投毒攻击的影响. 然而, 该方案假设服务器端部署了一个预测模型. 进一步地, Zhao

等人 [29] 利用 GAN 在训练过程中生成审计数据, 通过审计其模型准确性来消除对手. 更近地, 为了检测金融欺诈检

测场景下基于 GAN 的投毒攻击并实施隐私保护, Qiao 等人 [16] 提出了一种隐私感知和增量防御 (PID) 方法, 通过

累积参与者模型参数的偏移量来表示模型参数的移动趋势, 以区分对手和正常参与者, 最后引入差分隐私保护技

术来保护 PID 中参与者训练数据的隐私信息, 但是该方法没有考虑参与者的贡献大小. (4) 着手于隐私角度. 为了

对抗移动边缘计算下的投毒攻击, Zhao 等人 [18] 开发了一种隐私保护方案, 利用特征学习模型从用户的位置数据中

推断出投毒位置. 此外, Liu 等人 [30] 集中于 IID 数据的隐私增强 FL (PEFL), 通过采用同态加密技术并基于梯度数

据来检测并惩罚投毒者, 但是这个方法对安全性做了较强的假设. Cao 等人 [19] 提出了一个集成 FL 框架 FLCert, 通

过将客户分成不同组来学习全局模型, 然后执行多数投票以对输入进行分类, 并为该过程提供可证明的安全保证,

以防御恶意客户端的投毒攻击. 然而, 上述方法未能对 non-IID 场景展开探讨. 进一步地, Ma 等人 [20] 设计了一种基

于同态加密技术的隐私保护防御策略 ShieldFL, 旨在通过测量两个加密梯度之间的距离并使用余弦相似度的拜占

庭容错聚合方法实现 IID 和 non-IID 数据的鲁棒性, 以抵抗加密模型投毒.

现有对抗投毒攻击的防御方法: (1) 大多依赖于连续更新空间, 面向离散更新空间开展防御机制的探讨仍然较

少; (2) 忽略了参与 FL 协作训练的客户端之间的公平性, 差异化的贡献度将诱发更强大的投毒攻击能力, 导致难以

检测出攻击者; (3) 基于隐私保护或针对特定的攻击场景, 可能不适用于 non-IID 场景; (4) 一些工作依赖于预先假

设, 比如, 假设防御者或服务器端拥有验证数据集或辅助模型, 这在 FL 中显然是不实际的.

2 威胁模型和防御能力

在本文中, 我们集中于 FL 辅助云边缘计算场景下的攻击设置, 而且, 我们考虑标签翻转攻击 (LFA) 方法 [31] .

其中, 小部分终端设备视为攻击者并试图将精心制作的恶意数据注入本地数据集, 执行本地训练, 使得在良性参与

者与攻击者之间形成差异化的模型更新和离散空间, 进而影响边缘聚合和全局聚合的性能, 同时, 这也会造成一种

现象: 具有较小贡献的攻击者搭便车良性参与者, 最终影响全局模型的性能. 更具体地, 我们从 3 个方面阐述威胁

模型: 攻击者的目标, 攻击者的知识和攻击者的能力, 相应地, 我们也介绍了防御者的能力. 为了方便, 我们给出了

一些符号及描述, 如表 1 所示.

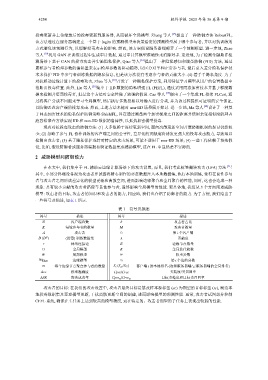

表 1 符号及描述

符号 描述 符号 描述

N 客户端总数 b 攻击者占比

K 每轮参与者的数量 M 攻击者数量

攻击者 c i i 个客户端

A 第

p

D (D ) (投毒) 训练数据集 λ 贡献度

e 网络连接边 E 边缘节点数量

G 全局模型 R 全局迭代轮数

W 局部模型 w 权重参数

边缘模型 i 个边的分数

W Edge s i 第

m 每个边缘节点聚合参与者的数量 S i (S g /S G ) 客户端 i 的本地排名 (边缘服务器端/云服务器端的全局排名)

Acc 模型准确度 Cpre/Crec 类精度/类召回率

ASR 攻击成功率 Cpre tc /Crec tc 目标类精度和目标类召回率

攻击者的目标: 在我们的攻击设置中, 攻击者最终目标是篡改样本源标签 (sc) 为期望的目标标签 (tc), 制造本

地投毒数据集及恶意模型更新, 干扰离散更新空间的创建, 进而影响模型的预测性能. 通常, 攻击者试图部分控制

CEFL 系统, 确保在主任务上达到较高的模型精度, 而在特定的、攻击者期望的子任务上表现出较弱的性能.