Page 335 - 《软件学报》2025年第7期

P. 335

3256 软件学报 2025 年第 36 卷第 7 期

对未标注节点添加伪标签信息. 伪标签技术对标记信息的扩增依赖于分类器的预测结果, 因此, 在初始数据集上,

对分类器训练精度具有较高的要求. 同时, 初始数据集的选择对分类器的训练也有一定影响.

与伪标签技术不同, 一致性正则化技术则是对样本进行扩增. 其基本思想是, 给定某个输入样本, 若对数据添

加扰动, 对于分类器而言, 其输出应当保持一致. 这种思想也是用于判断当前分类器是否过拟合的标准, 因此, 基于

一致性正则化技术的数据扩增方法的主要手段是强制使模型对添加扰动后的数据的预测输出与原始数据的预测

输出结果保持一致. 其分类器训练过程是, 对于数据域中的样本, 通过各种手段为其添加扰动, 在训练过程中, 使用

度量函数计算添加扰动后的数据项与原始数据分别对应的预测结果的差异, 并迭代训练, 使该差异最小化. 研究结

果表明, 这一做法可以减少分类器过拟合, 有效地提升分类器的泛化性能, 特别是当数据域中的样本数量不足时. π

-model 算法 [51] 是最先被提出的一种一致性正则化方法, 其做法是使用数据增强技术为某样本添加扰动, 分类模型

分别给出该样本对应的增强样本的输出结果, 使用此结果计算预测输出的差异值, 并强制该值最小化. 在这一算法

思想的基础上, 研究人员又开发了其他在数据中添加扰动的方法 [52−54] , 例如: 当数据形式为图像时, 通过设计合理

的搜索策略对平移、旋转、翻转或随机裁剪后的原始图像进行变换等 [52] , 在实际任务中取得了良好的效果. 此外,

对抗训练的思想也大量被用于这一领域, 即采用两个模型之间进行竞争的方式获得有利于提高分类器泛化能力的

样本, 从而达到对原始数据进行扩增的目的. 比较有代表性的工作包括: VAT 模型 [55] , 其一致性正则化过程是使所

生成的对抗样本的预测结果与原始数据对应的预测结果一致; Mean teacher [56] 算法, 其一致性正则化过程是使两个

网络的结构一致, 其中一个网络的参数为另一个网络参数的指数移动平均值. 此外, 在一致性正则化损失的衡量方

面, 研究人员通常采用均方误差 [51] 或交叉熵损失函数 [53] 等计算模型输出的差异.

2 基于扩增技术的无监督域适应方法

在现有工作的基础上, 本文将数据扩增技术引入到无监督域适应任务中. 分别引入了伪标签技术对目标域中

的样本标记进行了扩增和一致性正则化技术对目标域中的样本进行了扩增. 在分类器的训练过程中, 使用最大均

值差异函数对两个数据域的分布差异进行计算, 通过最小化扩增后数据集上的分布差异达到分类器在目标域上性

能提升的目的.

2.1 问题形式化

{( s s )} n s s d s s

i

假定源域 D s = x ,y , 其中 x ∈ R . 其中, x ∈ X s 表示第 个 d 维样本, y ∈ Y s 表示该样本对应的标注. n s 表

i i i=1 i i i

{ } n t

d

t

示源域中的样本数量, X s 表示源域样本集, Y s 表示源域标记集. 令目标域为 D t = x t , 其中 x ∈ R 表示第 个 d

j

j j=1 j

维样本, n t 表示目标域中的样本数量, 则无监督域适应学习问题可形式化为:

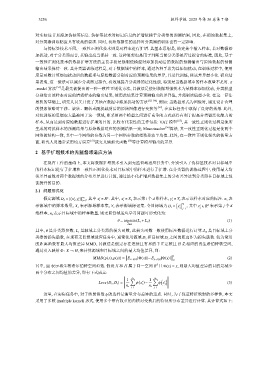

θ = argmin(L s + L d ) (1)

θ∈Θ

其中, θ 是分类器参数, L s 是源域上分类器的损失函数, 此损失函数一般使用标注数据进行计算. L d 是目标域上分

类器的损失函数, 在现有无监督域适应任务中, 通常使用源域 D s 和目标域 D t 之间的距离作为损失函数. 较为常用

的距离函数有最大均值差异 MMD, 其做法是假定存在连续且有界的半正定核且 H 是相应的再生希伯特核空间,

通过引入映射 Φ : X → H, 来计算源域和目标域之间的最大均值差异, 即:

2

MMD(p(x), p(y)) =

E x∼p(x) [Φ(x)]− E y∼p(y) [Φ(y)]

(2)

H

d

其中, ∥·∥ 表示再生核希尔伯特空间范数. 假设 X 和 H 属于同一空间 R 且 Φ(x) = x, 则最大均值差异的目的是减少

两个分布之间均值的差异, 即有下式成立:

n s ∑

1 ( ) 1 n t ∑ ( )

s

t

Loss(D s ,D t ) =

ϕ x − ϕ x

(3)

i

j

n s n t

i=1 j=1

这里, 在实际任务中, 对于映射函数 ϕ 的选择是衡量分布差异的重点. 同时, 为了保证特征映射的多样性, 本文

采用了多核 (multiple kernel) 形式, 使用多个带有权重的内核对变换后的特征所分布差异进行计算. 其计算式如下: