Page 359 - 《软件学报》2025年第5期

P. 359

乐紫莹 等: 基于梯度放大的联邦学习激励欺诈攻击与防御 2259

平均值作为新的全局模型参数中该维度的值; FLTrust 要求联邦服务器持有一个额外的验证数据集, 基于参与者上

传的梯度与使用验证数据集训练得到的梯度之间的余弦相似性给予信任评分, 并对参与者上传梯度的幅度进行归

一化处理, 最终使用信任评分对其归一化后的本地模型梯度进行加权计算来得到新的全局模型.

上述这些防御机制能够防止目前存在的大部分影响模型性能的攻击, 但激励欺诈攻击可以通过上传满足系统

对模型性能要求的梯度来获取额外激励, 因此, 现有的防御机制很难防御激励欺诈攻击, 需要设计针对性的防御机

制来有效防御激励欺诈攻击.

2 激励欺诈攻击问题

t

本节形式化定义激励欺诈攻击. 对联邦学习中的任意一轮训练 t , 记 (w,n) 为一个攻击者在第 轮通过诚实训

练 (即严格遵守学习算法进行的训练) 产生的本地模型信息, 其中 w 为模型参数, n 为本地训练数据集大小; 记

t

( ˜w, ˜n) 为该攻击者在第 轮产生的欺诈本地模型信息, 其中 ˜ w 为欺诈模型参数, ˜ n 为欺诈的数据集大小. 类似地, 记

(w,n) 所付出的训练代价; 记

R(w,n) 为攻击者通过提交诚实本地模型信息 (w,n) 所获得的激励, C(w,n) 为产生

R( ˜w, ˜n) 为攻击者提交欺诈本地模型信息 ( ˜w, ˜n) 所获得的欺诈激励, C( ˜w, ˜n) 为所付出的欺诈训练代价. 记 ∆R =

R( ˜w, ˜n)−R(w,n) , 我们有如下定义.

定义 1. 激励欺诈攻击. 对联邦学习中的任意一轮训练, 给定阈值 µ > 0 , 激励欺诈攻击是一个攻击者通过提交

欺诈本地模型信息 ( ˜w, ˜n) 获得激励成本比 R ⩾ µ 的行为, 其中 R 的计算方式如公式 (5) 所示:

∆R

R = (5)

C( ˜w, ˜n)/C(w,n)

由公式 (5) 可得, R 为参与者进行欺诈攻击后使用攻击计算代价相较于诚实计算代价的提升比对参与者欺诈

攻击后的激励提升值进行缩放所得的激励值, 只有当欺诈攻击后获得的激励成本比 R 不小于阈值 µ 时, 参与者才

愿意实施激励欺诈攻击.

激励欺诈攻击虽然不会直接影响联合模型的性能, 但是会影响到激励机制的运行, 由此导致的不合理的激励

分配会降低优质数据持有者参与联邦学习的积极性, 从而间接影响到最终模型的性能.

恶意参与者实施激励欺诈攻击时必须在通过联邦学习系统防御机制的前提下提高激励, 因此本文假定恶意参

与者在实施激励欺诈攻击行为时有如下背景知识.

(1) 了解联邦学习系统采用的激励分配机制与防御机制, 如系统使用 Refiner 中的模型评估机制, 恶意参与者

也能够知道系统预设定的模型检验阈值.

(2) 拥有一个与服务器使用的测试数据集 D U 分布近似的验证数据集 D V .

(3) 知道前 e 轮其他参与者上传的本地模型信息, e 的取值与系统采用的防御机制相关.

3 梯度放大攻击 GSupA

3.1 攻击总览

Bagdasaryan 等人 [9] 提出的构造适用于联邦学习的后门攻击模型的方法中, 为了让训练得到的后门攻击模型

在多次模型聚合后仍然能够保持一定的性能, 而不让聚合后的模型遗忘后门数据, 消去后门攻击模型的贡献, 攻击

者对攻击模型梯度进行了放大, 来增加模型聚合时攻击模型的权重, 提高其对聚合模型的影响. 模型梯度放大后的

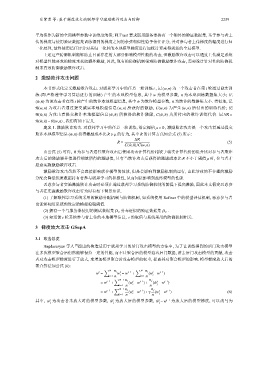

聚合算法如公式 (6):

∑ ∑

N n i N n i

t

t

t

t−1

w = w = w t−1 + (w −w )

i=1 n i i=1 n i

∑ N−1 n i n j

t−1

t

t−1

t

= w t−1 + (w −w )+ ( ˜w −w )

i=1 n i n j

∑

N−1 n i n j

t−1

t

t

t−1

= w t−1 + (w −w )+γ (w −w ) (6)

i=1 n i n j

t t t t−1 为放大后的模型梯度, 可以改写为

其中, w 为攻击者未放大时的模型参数, ˜ w 为放大后的模型参数, ˜ w −w

j

j

j