Page 279 - 《软件学报》2025年第5期

P. 279

琚江舟 等: 多粒度单元格对比的文本和表格数值问答模型 2179

用于优化模型参数, 学习率是 2.0E–5, 采用线性预热方案在前 100 步数据上进行学习率预热. 训练的 batch size 为

16, 训练的 epochs 是 60. 本文随机采样的正例数目 K1 为 20, 负例数目 K2 为 10, 这里 K1 和 K2 代表最多采样个数.

4.5 主要实验结果

本节主要展示基准模型与引入多粒度单元格语义对比 (MGCC) 的模型在 FinQA 和 MultiHiertt 数据集上性能

表现.

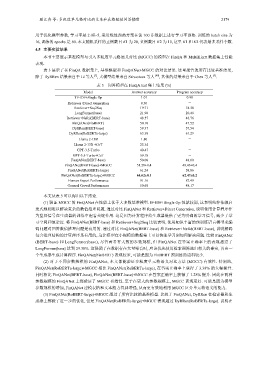

表 3 展示了在 FinQA 数据集上, 基准模型和 FinQANet+MGCC 的对比结果. 这里报告的所有比较基准结果,

除了 DyRRen 结果来自于 Li 等人 [7] , 大模型结果来自 Srivastava 等人 [40] , 其他的结果来自于 Chen 等人 [5] .

表 3 问答模型在 FinQA test 集上结果 (%)

Model Answer accuracy Program accuracy

TF-IDF+Single Op 1.01 0.90

Retriever+Direct Generation 0.30 -

Retriever+Seq2Seq 19.71 18.38

LongFormer(base) 21.90 20.48

Retriever+NeRd(BERT-base) 48.57 46.76

FinQANet(FinBERT) 50.10 47.52

DyRRen(BERT-base) 59.37 57.54

DyRRen(RoBERTa-large) 63.30 61.29

Llama 2-13B 1.80 -

Llama 2-13B +CoT 25.34 -

GPT-3.5-Turbo 40.47 -

GPT-3.5-Turbo+CoT 59.18 -

FinQANet(BERT-base) 50.00 48.00

FinQANet(BERT-base)+MGCC 51.28±0.4 49.43±0.4

FinQANet(RoBERTa-large) 61.24 58.86

FinQANet(RoBERTa-large)+MGCC 64.62±0.1 62.47±0.2

Human Expert Performance 91.16 87.49

General Crowd Performance 50.68 48.17

本文从表 3 可以得出以下结论.

(1) 验证 MGCC 的 FinQANet 在性能上优于大多数基准模型. IF-IDF+Single Op 性能较弱, 这表明纯粹依赖启

发式规则难以解决复杂的数值推理问题. 通过对比 FinQANet 和 Retriever+Direct Generation, 说明使用计算程序作

为监督信号在生成器的训练中起着关键作用. 这是因为计算程序给生成器提供了更为明确的学习信号, 减少了学

习空间和复杂度. 将 FinQANet(BERT-base) 和 Retriever+Seq2Seq 比较表明, 使用知识丰富的预训练语言模型来编

码问题对回答数值推理问题是有用的. 通过对比 FinQANet(BERT-base) 和 Retriever+NeRd(BERT-base), 说明解码

包含推理结构的计算程序是有用的, 这让模型在小规模的数据集上可以快速学习到如何解决问题. 比较 FinQANet

(BERT-base) 和 LongFormer(base), 尽管两者有大致的参数规模, 但 FinQANet 在答案正确率上的表现超过了

LongFormer(base) 达到 29.38%. 这强调了在数据存在大量噪音时, 应该优先使用检索器筛选出相关的事实, 再由一

个生成器生成计算程序. FinQANet(FinBERT) 表现较差, 可能是因为 FinBERT 预训练的语料较少.

(2) 对于不同参数规模的 FinQANet, 本文都能验证多粒度单元格语义对比方法 (MGCC) 有效性. 特别地,

FinQANet(RoBERTa-large)+MGCC 相比 FinQANet(RoBERTa-large), 在答案正确率上获得了 3.38% 的大幅提升.

同时相比 FinQANet(BERT-base), FinQANet(BERT-base)+MGCC 在答案正确率上获得了 1.28% 提升. 因此在两种

参数规模的 FinQANet 上都验证了 MGCC 有效性. 至于在更大的参数规模上, MGCC 表现更好. 可能是因为模型

参数规模的增加, FinQANet 建模表格和文本能力得到增强, 从而更有效地利用 MGCC 区分单元格语义的能力.

(3) FinQANet(RoBERT-large)+MGCC 超过了所有比较的基准模型. 比较于 FinQANet, DyRRen 在检索器和生

成器上都做了进一步的优化, 但是 FinQANet(RoBERTa-large)+MGCC 表现超过 DyRRen(RoBERTa-large). 说明在