Page 322 - 《软件学报》2024年第4期

P. 322

1900 软件学报 2024 年第 35 卷第 4 期

impact of low-quality depth maps, the study also designs a cross-modal interactive fusion module to realize cross-modal feature fusion.

Finally, experimental results on five benchmark datasets show that the proposed algorithm has an excellent performance than other latest

algorithms.

Key words: salient object detection (SOD); cross-modal; global attention mechanism; RGB-D detection model

显著性目标检测 (salient object detection, SOD) 的目的是找到并分割图像中视觉上最显著的目标 [1,2] . 在过去

10 年中, 因其在目标识别 [3] 、基于内容的图像检索 [4] 、目标分割 [5] 、图像编辑 [6] 、视频分析 [7,8] 和视觉跟踪 [9,10] 中

的广泛应用而备受关注.

随着 CNN 的发展, RGB 显著性目标检测 [11,12] 逐渐突破了传统方法 [13,14] 的性能瓶颈, 取得了良好的效果. 然而,

在某些复杂场景 (例如, 杂乱的背景、多个对象、不同的光照、透明对象等) 中检测效果往往并不理想 [15] , 主要原

因在于缺乏空间位置信息, 这对于显著性目标检测至关重要. 例如, 在某些显著性物体与背景对比度较低时, 只靠

RGB 图像很难区分物体与背景.

近年来, 带有深度信息的 RGB-D 显著性目标检测, 凭借深度图中所含丰富的空间结构、3D 布局以及目标边

界等有用信息 [16] , 在具有挑战性的场景中能够取得出色的性能. 同时, 3D 成像传感器技术的快速发展 [17] , 降低了

深度图像的获取成本, 促进了基于 RGB-D 显著性目标检测的相关研究 [18,19] , 有效地解决了传统 SOD 存在的问题.

尽管如此, 现有的 RGB-D 显著性目标检测模型仍面临持续提升性能的挑战. 解决这一挑战, 可以采用如下 2 种思路.

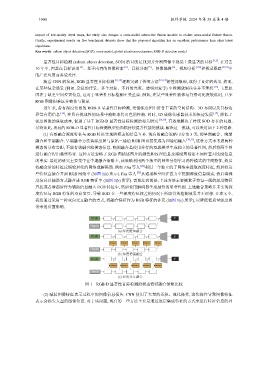

(1) 有效融合深度特征与 RGB 特征实现跨模态的信息互补. 现有的融合策略可分为 3 类, 即早期融合、晚期

融合和中期融合. 早期融合方法将深度图与原始三通道 RGB 图直接集成为四通道输入 [20,21] , 这种方式未考虑两种

模态的分布差距, 不能有效融合跨模态信息. 晚期融合是使用并行的双流模型生成独立的显著性图, 然后将两个图

进行融合得出最终特征. 这种方法忽略了 RGB 图描述图片的颜色和纹理信息及深度图描述不同位置对比度信息

的事实. 最近的研究主要集中在中期融合策略上, 该策略利用两个独立的网络分别学习两种模式的中间特征, 然后

将融合后的特征反馈给后续的网络或解码器. 例如 Zhu 等人 [22] 利用一个独立的子网络来提取深度特征, 然后将这

些特征直接合并到 RGB 网络中 (如图 1(a) 所示). Fan 等人 [23] 从通道和空间注意力中挖掘深度信息线索, 然后将深

度信息以辅助方式融合进 RGB 特征中 (如图 1(b) 所示). 需要注意的是, 上述方法主要侧重于将每一级的深度特征

直接或者增强后作为辅助信息融入 RGB 特征中, 然后使用解码器生成最终的显著性图. 上述融合策略并未实现深

度特征与 RGB 特征的双向交互, 导致 SOD 在一些深度特征较差的情况下所取得的检测效果并不理想. 在本文中,

我们通过采用一种双向交互融合的方式, 将融合特征作为 RGB 特征的补充 (如图 1(c) 所示), 以降低低质量深度图

带来的负面影响.

RGB P

Depth

(a) 深度附加融合

RGB P

Enhance Enhance Enhance Enhance Enhance

Depth

(b) 深度增强融合

RGB P

Enhance Enhance Enhance Enhance Enhance

Depth

(c) 双向交互融合

图 1 RGB-D 显著性目标检测跨模态特征融合策略比较

(2) 减轻图像特征表示过程中的图像信息损失. CNN 使用了大量的卷积、池化操作, 这些操作导致图像特征

表示会损失大量的图像信息. 对于该问题, 现有的一些方法主要是通过逐层集成特征的方式来进行特征信息的补