Page 316 - 《软件学报》2024年第4期

P. 316

1894 软件学报 2024 年第 35 卷第 4 期

嵌入表示输入到一个图注意力网络中, 在表中我们称其为仅使用图注意力网络. 我们可以看到槽 F1 分数也呈现下

降趋势. 通过分析, 我们将异构交互结构的优势归功于自注意力机制可以准确捕捉词级节点之间的特征, 而图注意

力网络可以将语义级节点信息传递给词级节点, 并且权重不共享. 同时, 我们使用了前面提到的异构图的 3 种边.

这两种方法使用不同的学习权重, 可以非自回归地更新每个节点的信息. 因为意图检测是粗粒度的句级分类任务,

槽位填充是相对细粒度的词级分类任务, 这两种任务信息是具有相互关联的不同粒度信息. 因此, 构造异构图可以

显式区别这两种类型的节点信息, 并且在特定特征空间中学习两种类型节点的非重叠特征知识, 从不同粒度的状

态信息中学习其潜在特征并进行集成.

表 2 单一组件消融实验 (%)

ATIS SNIPS

消融实验

Intent Acc Slot F1 Overall Acc Intent Acc Slot F1 Overall Acc

HcoSG 97.98 96.10 88.02 99.11 96.11 90.35

两级意图解码器消融实验 97.53 95.57 87.34 98.85 95.62 89.43

仅使用自注意力机制 97.76 96.00 87.68 98.71 95.90 89.73

仅使用图注意力网络 97.42 95.89 87.23 98.85 95.88 89.88

窗口机制消融实验 97.74 95.82 87.12 98.57 95.82 89.43

意图感知槽填充解码器消融实验 97.54 95.67 86.90 98.71 95.65 89.29

此外, 这部分结构最终用于槽位填充任务. 如前所述, 给定两个特定任务, 我们的模型可以学习路径中节点及

其邻居之间的注意力值. 一些对不同特定任务有用的重要邻居往往具有更大的注意力值. 词级节点的更新过程包

含两种抽象边, 即意图-槽连接边和槽-槽连接边. 由于两种类型的边使用不同的学习权重, 因此可以将词级槽信息

与更丰富的句级语义信息相结合.

(3) 窗口机制消融实验

f window (·) 函数的功能. 表 2 表明窗口

本部分研究是进行窗口机制消融实验, 可以认为去除了自注意力机制中

机制是为实现更好性能所必需的. 从结果可以看出, 所有的评价指标都下降了, 这意味着我们忽略了槽位信息的时

间顺序和位置, 即忽略了“O”标签局部出现的特性以及“B-”“I-”成对出现的局部性. 由于槽位填充和意图检测是两

个相关性很强的任务, 利用槽的局部连续性可以更好地解码节点特征, 也可以更好地捕获“B-”“I-”槽信息来指导意

图识别任务.

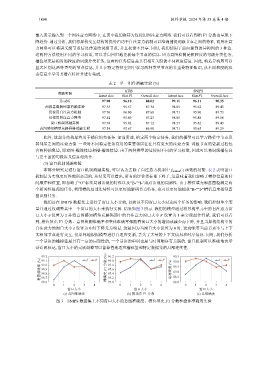

我们还在 SNIPS 数据集上进行了窗口大小实验, 以验证不同窗口大小对这两个任务的影响. 我们控制单个变

量并通过仅调整其中一个窗口的大小来执行实验. 结果如图 3 所示. 我们的模型通过将异构单元中的自注意力窗

′

口大小 δ 设置为 2 并将意图感知槽填充解码器中的自注意力窗口大小 δ 设置为 1 来实现最佳性能. 我们可以看

到, 槽位填充 F1 分数、意图检测准确率和整体准确率都随着窗口大小的增加或减少而下降, 并且当异构结构中的

自注意力的窗口大小 δ 设置为 0 时下降尤为明显. 这是因为当窗口大小设置为 0 时, 这意味着当前节点不与上下

文相邻节点进行交互, 仅单纯地根据模型进行自适应更新, 丢失了大量的上下文信息和时序信息. 同时, 我们分析

一个话语的槽标签是具有一定的局部性的, 一个话语的单词也是与时间顺序有关联的. 窗口机制可以准确地表示

话语的标记, 窗口大小的灵活调整可以鲁棒性地适应槽标签和特定数据集的局部连续性.

99.2 δ δ′ 96.2 δ δ′ 90.5 δ δ′

意图准确率 (%) 99.0 槽填充 F1 分数 (%) 95.8 总准确度 (%) 89.5

96.0

99.1

90.0

95.6

98.9

89.0

98.8

95.4

98.7

88.0

98.6 95.2 88.5

95.0

0 1 2 3 4 0 1 2 3 4 0 1 2 3 4

窗口大小 窗口大小 窗口大小

(a) 意图准确率 (b) 槽填充 F1 分数 (c) 总准确度

图 3 SNIPS 数据集上不同窗口大小的意图准确度、槽位填充 F1 分数和整体准确度实验