Page 19 - 《软件学报》2024年第4期

P. 19

刘鑫 等: 基于多样真实任务生成的鲁棒小样本分类方法 1597

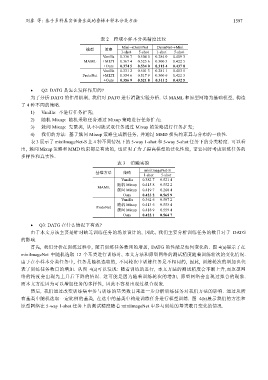

表 2 跨域小样本分类精度比较

Mini→DermNet DermNet→Mini

模型 策略

1-shot 5-shot 1-shot 5-shot

Vanilla 0.336 7 0.504 0 0.284 0 0.409 3

MAML +MLTI 0.367 4 0.525 6 0.300 3 0.422 5

+Ours 0.374 5 0.534 0 0.312 4 0.437 8

Vanilla 0.331 2 0.501 3 0.281 1 0.403 5

ProtoNet +MLTI 0.354 6 0.517 9 0.300 6 0.422 3

+Ours 0.356 9 0.521 8 0.311 2 0.432 5

• Q2: DATG 是怎么发挥作用的?

为了分析 DATG 的作用机制, 我们对 DATG 进行消融实验分析. 以 MAML 和原型网络为基础模型, 构造

了 4 种不同的策略.

1) Vanilla: 不进行任务扩充;

2) 随机 Mixup: 随机采取任务通过 Mixup 策略进行任务扩充;

3) 簇间 Mixup: 先聚类, 从不同簇采取任务通过 Mixup 的策略进行任务扩充;

4) 我们的方法: 基于簇间 Mixup 策略生成新任务, 并通过 MMD 损失约束其与分布的一致性.

表 3 展示了 miniImageNet-S 上 4 种不同情况下的 5-way 1-shot 和 5-way 5-shot 任务下的分类精度. 可以看

出, 簇间 Mixup 策略和 MMD 约束都是有效的, 也证明了为了提高模型的泛化性能, 需要同时考虑训练任务的

多样性和真实性.

表 3 消融实验

miniImageNet-S

基准方法 策略

1-shot 5-shot

Vanilla 0.382 7 0.521 4

随机 Mixup 0.415 8 0.552 2

MAML

簇间 Mixup 0.419 7 0.260 4

Ours 0.423 2 0.565 9

Vanilla 0.362 6 0.507 2

随机 Mixup 0.413 6 0.553 4

ProtoNet

簇间 Mixup 0.418 9 0.559 4

Ours 0.422 1 0.564 7

• Q3: DATG 在什么情况下有效?

由于本文方法主要是针对缺乏训练任务的场景设计的, 因此, 我们主要分析训练任务的数目对于 DATG

的影响.

首先, 我们分析在训练过程中, 随着训练任务数目的增加, DATG 的性能是如何变化的. 图 4(a)展示了在

miniImageNet 中随机选取 12 个基类进行训练时, 本文方法和原型网络的测试精度随着训练轮次的变化情况.

由于在小样本分类任务中, 任务是随机选取的, 不同轮次中训练任务是不相同的, 因此, 训练轮次的增加也代

表了训练任务数目的增加. 从图 4(a)可以发现: 随着训练的进行, 本文方法的测试精度会不断上升,而原型网

络的精度会出现先上升后下降的情况. 这可能是因为随着训练轮次的增加, 原型网络会出现过拟合的现象.

而本文方法因为可以增加任务的多样性, 因此不容易出现过拟合现象.

然后, 我们通过改变训练集中参与训练的基类数目来进一步分析训练任务对我们方法的影响. 通过从所

有基类中随机选取一定比例的基类, 在选中的基类中构造训练任务进行模型训练. 图 4(b)展示我们的方法和

原型网络在 5-way 1-shot 任务上的测试精度随着 miniImageNet 中参与训练的基类数目变化的情况.