Page 149 - 《软件学报》2024年第4期

P. 149

闫涛 等: 一种分组并行的轻量化实时微观三维形貌重建方法 1727

表 4 4D Light Field 数据集和 DefocusNet 数据集的定量评价

4D Light Field [33] DefocusNet [7]

Methods

MSE RMSE Bump MSE MAE AbsRel

[5]

FVNet 0.030 1 0.153 7 − 0.018 9 − 0.140 0

[5]

DFVNet 0.031 7 0.154 9 − 0.020 5 − 0.130 0

[6]

DDFF 0.115 0 0.331 0 2.95 0.044 0 0.131 2 0.355 6

[7]

DefocusNet 0.059 3 0.235 5 2.69 0.017 5 0.063 7 0.138 6

[8]

AiFDepthNet 0.047 2 0.201 4 1.58 0.012 7 0.054 9 0.111 5

GPLWS-Net 0.027 5 0.144 2 2.49 0.010 6 0.053 4 0.139 4

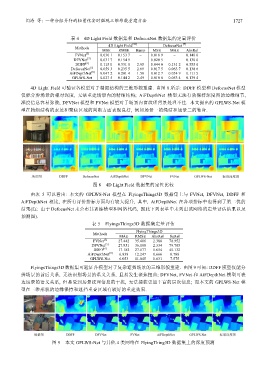

4D Light Field 可验证各模型对于精细结构的三维形貌重建. 由图 8 所示: DDFF 模型和 DefocusNet 模型

仅能分辨场景的相对深度, 无法重建场景内的精细结构; AiFDepthNet 模型无法有效保持深度图的边缘细节,

深度信息容易弥散; DFVNet 模型和 FVNet 模型对于场景内富纹理背景处理不佳. 本文提出的 GPLWS-Net 模

型在精细结构的表达和聚焦区域的判断方面表现良好, 例如场景一的绳结和场景二的鞋身.

图 8 4D Light Field 数据集的定性比较

由表 5 可以看出: 本文的 GPLWS-Net 模型在 FlyingsThings3D 数据集上与 FVNet, DFVNet, DDFF 和

AiFDepthNet 相比, 在所有评价指标方面均有较大提升, 其中, AiFDepthNet 在各项指标中也得到了第二优的

结果(注: 由于 DefocusNet 未公布其训练模型和网络代码, 因此下列表单中未列出该网络的定量评估结果以及

预测图).

表 5 FlyingsThings3D 数据集定量评估

FlyingThings3D

Methods MAE RMSE AbsRel SqRel

[5]

FVNet 27.442 35.406 2.388 78.952

[5]

DFVNet 27.951 36.098 2.334 79.705

[6]

DDFF 17.182 27.077 1.654 45.132

[8]

AiFDepthNet 6.838 12.247 0.666 8.788

GPLWS-Net 6.053 11.045 0.631 7.575

FlyingsThings3D 数据集可验证各模型对于复杂遮挡场景的三维形貌重建. 由图 9 可知: DDFF 模型仅能分

辨场景的前后关系, 无法识别场景的语义关系, 且易发生聚焦扭曲; DFVNet, FVNet 和 AiFDepthNet 模型可表

达场景的语义关系, 但易受到场景纹理信息的干扰, 无法捕获更加丰富的层次信息; 而本文的 GPLWS-Net 模

型在三维形貌的边缘保持和遮挡重叠区域有较好的重建效果.

图 9 本文 GPLWS-Net 与其他 4 类网络在 FlyingThing3D 数据集上的深度预测