Page 108 - 《软件学报》2024年第4期

P. 108

1686 软件学报 2024 年第 35 卷第 4 期

间的内部连接节点数量 n 为预先定义的超参数. 基于微观搜索空间的搜索方式更为灵活, 且搜索复杂度更低.

但相较宏观搜索空间, 微观搜索空间获得的神经网络可解释性较弱.

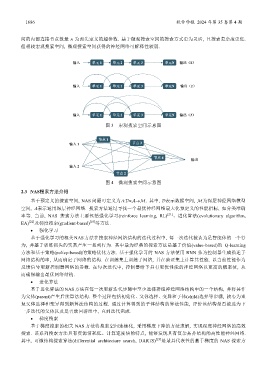

图 3 宏观搜索空间示意图

图 4 微观搜索空间示意图

2.3 NAS搜索方法介绍

基于预定义的搜索空间, NAS 问题可定义为Λ:×→. 其中, 表示数据空间, 为深层神经网络模型

空间, Λ表示通用深层神经网络. 搜索方法通过寻找一个最优神经网络最大化预定义的性能指标, 如分类准确

率等. 当前, NAS 搜索方法主要包括强化学习(reinforce learning, RL) [21] 、进化算法(evolutionary algorithm,

EA) [22] 及梯度搜索(gradient-based) [10] 等方法.

• 强化学习

基于强化学习的相关 NAS 方法在搜索神经网络结构的迭代过程中, 每一次迭代被认为是智能体的一个行

为, 并基于训练损失的奖赏产生一系列行为. 其中最为经典的搜索方法是基于价值(value-based)的 Q-learning

方法和基于策略(policy-based)的策略优化方法. 基于强化学习的 NAS 方法使用 RNN 作为控制器生成描述子

网络结构的串, 从而确定子网络的结构. 在训练集上训练子网络, 并在验证集上计算其性能. 以当前性能作为

反馈信号更新控制器网络的参数. 在每次迭代中, 控制器给予具有更优性能的神经网络以更高的概率值, 从

而确保输出最优网络结构.

• 进化算法

基于进化算法的 NAS 方法在每一次更新迭代步骤中至少选择群组神经网络结构中的一个结构, 并将其作

为父体(parent)产生后续算法结构. 整个过程包括初始化、父体选择、变异和子体(child)选择等步骤, 核心为重

复父体选择和变异得到新算法结构的过程. 通过计算得到的子体结构的算法性能, 评价该结构是否被选为下

一步迭代的父体以及是否放回群组中, 直到迭代完成.

• 梯度搜索

基于梯度搜索的相关 NAS 方法将搜索空间连续化, 采用梯度下降的方法求解, 实现深度神经网络的高效

搜索. 该系列搜索方法具有资源消耗低、计算速度快的特点, 能够发现具有复杂拓扑结构的高性能神经网络.

其中, 可微结构搜索算法(differential architecture search, DARTS) [23] 是最具代表性的基于梯度的 NAS 搜索方