Page 201 - 《软件学报》2021年第12期

P. 201

谌明 等:一种基于注意力联邦蒸馏的推荐方法 3865

史点击次数),last7onlinetime(过去 7 天的在线时长)等之间存在较强的特征交互,表明用户活跃度如点击次数和

在线时长等特征对产品购买影响较大,符合现实业务中的观察结论.该结果表明:本文提出的 Attention 策略可以

提取出更丰富的特征表征信息(无需通过 Attention 网络进行训练),增强设备数据,提升模型精度.

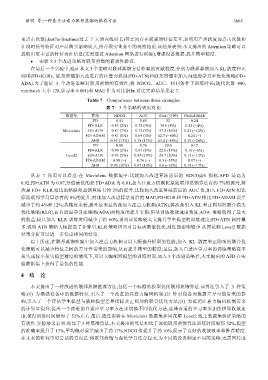

• 实验 5:3 个改进策略对联邦蒸馏的有效性验证.

在最后一个实验中,验证本文 3 个策略对联邦蒸馏方法框架的贡献程度,分别为联邦蒸馏加入 KL 散度和正

则项(FD+KLR)、联邦蒸馏加入改进后的注意力机制(FD+ATN)和联邦蒸馏中加入自适应学习率优化策略(FD+

ADA).为了验证 3 个改进策略对联邦蒸馏的有效性,将 NDCG、AUC、相同条件下训练时长(迭代次数 400,

minibatch 大小 128,学习率 0.001)和 MAE 作为对比指标.对比实验结果见表 7.

Table 7 Comparisons between three strategies

表 7 3 个策略的效果对比

数据集 算法 NDCG AUC Time (分钟) Global-MAE

FD 0.81 0.69 32 0.24

FD+KLR 0.83 (2%) 0.72 (4%) 34.6 (8%) 0.23 (−4%)

Movielens FD+ATN 0.87 (7%) 0.75 (8%) 37.2 (16%) 0.21 (−12%)

FD+ADAM 0.81 (0%) 0.69 (0%) 12.7 (−60%) 0.24 (−)

AFD 0.92 (13%) 0.78 (13%) 13.4 (−58%) 0.19 (−20%)

FD 0.88 0.76 20.6 0.17

FD+KLR 0.90 (2%) 0.81 (6%) 22.6 (13%) 0.16 (−6%)

Level2 FD+ATN 0.93 (5%) 0.84 (10%) 24.7 (20%) 0.15 (−12%)

FD+ADAM 0.88 (−) 0.76 (−) 9.3 (−55%) 0.17 (−)

AFD 0.96 (10%) 0.87 (14%) 9.8 (−52%) 0.14 (−17%)

从表 7 结果可以看出:在 Movielens 数据集中:比较加入改进算法前后的 NDCG@5 指标,AFD 最高为

0.92,FD+ATN 为 0.87,分值最低的是 FD+ADA 为 0.81;加入注意力机制比原始联邦蒸馏算法有约 7%的提升,其

次是 FD+ KLR,相比原始联邦蒸馏算法有约 2%的提升;比较加入改进算法前后的 AUC 值,加入 FD+ATN 相比

原始联邦学习算法有约 8%的提升;对比加入改进算法前后的 MAE,FD+KLR 和 FD+ATN 相比 FD+ADAM 误差

减少了约 4%和 12%;从精度来看,提升最明显的是加入注意力机制(ATN),其次是引入 KL 和正则项的联合损失

优化策略(KLR),而自适应学习率策略(ADA)对精度的提升有限;但从训练收敛速度角度,ADA 策略取得了最大

的收益,较只加入 KLR 训练时间减少了约 60%,说明该策略能大大提升学生模型的训练速度;FD+ATN 耗时最

多,说明 ATN 策略大幅提高了计算量;KLR 策略因只对目标函数做优化,对性能影响较少.从同花顺 Level2 数据

结果分析可以进一步得出相同的结论.

综上所述,在联邦蒸馏框架中加入注意力机制可以大幅提升模型的性能;加入 KL 散度和正则项的联合优

化策略可以减少特征之间的差异性带来的影响,从而提升模型的精度;最后,加入自适应学习率的训练策略在不

损失或较小损失模型精度的情况下,可以大幅缩短模型的训练时间.加入 3 个改进策略后,本文提出的 AFD 在实

验数据集上获得了最优的性能.

4 结 论

本文提出了一种改进的联邦蒸馏推荐方法,包括一个标准的模型优化联邦蒸馏算法.该算法引入了 3 种策

略:(1) 为增强设备中的数据特征,引入了一个改进的注意力编码机制;(2) 针对设备间数据差异可能带来的影

响,引入了一个评估学生模型与教师模型差异指标及正则项的联合优化方法;(3) 为抵消注意力编码机制带来

的计算量提升,提出一个改进的自适应学习率方法来切换不同优化方法,选择合适的学习率来加快模型收敛速

度,使得训练时间缩短了 52%左右.最后,通过实验在 Movielens 数据集和同花顺 Level2 线上数据集验证策略的

有效性.实验结果表明:相比于 3 种基准算法,本文提出的算法相比于原始联邦蒸馏算法训练时间缩短 52%,模型

的准确率提升了 13%,平均绝对误差减少了约 17%,NDCG 值提升了约 10%,展示了良好的收敛效率和推荐精度.

在未来的研究中可尝试的方向是:将联邦蒸馏与强化学习结合起来,为不同的设备制定不同的策略,无需回传或