Page 148 - 《软件学报》2021年第12期

P. 148

3812 Journal of Software 软件学报 Vol.32, No.12, December 2021

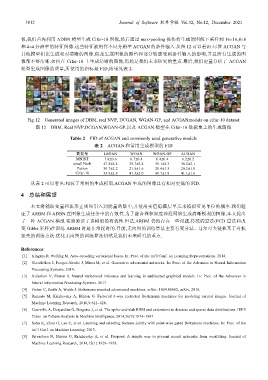

像,我们首先利用 ADBN 模型生成 Cifar-10 图像,然后通过 max-pooling 操作将生成的图像下采样到 16×16,8×8

和 4×4 分辨率的特征图像.这些特征被用作不同分辨率 ACGAN 的条件输入.从图 12 可以看出:尽管 ACGAN 与

其他模型相比生成相对清晰的图像,但是生成图像的颜色和部分轮廓受到条件输入的影响,并且所有生成的图

像都不够清晰.如何在 Cifar-10 上生成清晰的图像,仍然是我们未来研究的重点.最后,我们定量分析了 ACGAN

模型生成图像的质量,所使用的指标是 FID,结果见表 2.

Fig.12 Generated images of DBM, real NVP, DCGAN, WGAN-GP, and ACGANmodels on cifar-10 dataset

图 12 DBM, Real NVP,DCGAN,WGAN-GP,以及 ACGAN 模型在 Cifar-10 数据集上的生成图像

Table 2 FID of ACGAN and commonly used generative models

表 2 ACGAN 和常用生成模型的 FID

数据集 LSGAN WGAN WGAN-GP ACGAN

MNIST 7.8±0.6 6.7±0.4 6.4±0.4 6.2±0.2

small Norb 47.2±2.4 39.7±2.4 39.1±2.3 38.2±2.1

Fasion 30.7±2.2 21.5±1.6 20.4±1.5 20.2±1.0

Cifar-10 53.9±2.8 41.3±2.0 40.7±1.8 41.1±1.6

从表 2 可以看出:相较于常用的生成模型,ACGAN 生成的图像具有相对更低的 FID.

4 总结和展望

本文将辅助变量和流形正则项引入到能量函数中,并使用实值隐藏层单元来模拟可见单位的概率.我们验

证了 ARBM 和 ADBN 在图像生成任务中的有效性.为了融合卷积深度神经网络生成清晰锐利的图像,本文提出

了一种 ACGAN 模型.实验验证了该模型的有效性.但是,ARBM 仍然存在一些问题,传统的算法(PCD 算法和改

变 Gibbs 采样)在训练 ARBM 时是非常耗时的.目前,无向图的训练算法主要有变分法、马尔可夫链和基于对抗

损失的训练方法.优化无向图的训练算法仍然是我们未来研究的重点.

References:

[1] Kingma D, Welling M. Auto-encoding variational bayes. In: Proc. of the Int’l Conf. on Learning Representations. 2014.

[2] Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial networks. In: Proc. of the Advances in Neural Information

Processing Systems. 2014.

[3] Kuleshov V, Ermon S. Neural variational inference and learning in undirected graphical models. In: Proc. of the Advances in

Neural Information Processing Systems. 2017.

[4] Fisher C, Smith A, Walsh J. Boltzmann encoded adversarial machines. arXiv: 1804.08682, arXiv, 2018.

[5] Ranzato M, Krizhevsky A, Hinton G. Factored 3-way restricted Boltzmann machines for modeling natural images. Journal of

Machine Learning Research, 2010,9:621−628.

[6] Courville A, Desjardins G, Bergstra J, et al. The spike-and-slab RBM and extensions to discrete and sparse data distributions. IEEE

Trans. on Pattern Analysis & Machine Intelligence, 2014,36(9):1874−1887.

[7] Sohn K, Zhou G, Lee C, et al. Learning and selecting features jointly with point-wise gated Boltzmann machines. In: Proc. of the

Int’l Conf. on Machine Learning. 2013.

[8] Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: A simple way to prevent neural networks from overfitting. Journal of

Machine Learning Research, 2014,15(1):1929−1958.