Page 176 - 《软件学报》2021年第11期

P. 176

3502 Journal of Software 软件学报 Vol.32, No.11, November 2021

V n+ 1 (S n E ) = max Q n+ ()a 1 (S n E ) (11)

a

其中, P ()a (S n E ) 为第 a 个通道上的用于更新所选节点值函数的图形卷积算子.

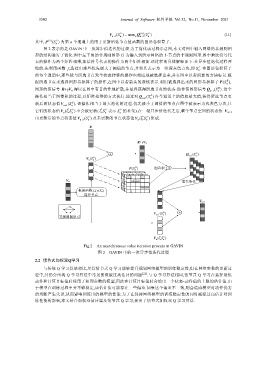

图 2 表示的是 GAVIN 中一次异步值迭代的过程.为了简化该过程示意图,本文对图中输入网络的非规则图

形的结构进行了简化.图中左下角的非规则图形 G 为输入到所示网络的 5-节点的非规则图形.图中乘法符号代

表的操作为两个矩阵相乘,加法符号代表的操作为两个矩阵相加.该过程的具体解释如下:在异步值迭代过程开

始前,先利用函数 f ν 选择出那些优先级大于阈值的节点,并将其表示为一组深灰色方块,即 S E . 在图形卷积算子

n

的每个通道中,那些能与所选节点发生状态转移的操作也相应地被选择出来,并在图中以带阴影的方块标记.根

据所选节点来选择图形卷积算子的操作,在图中以带箭头的虚线表示.利用被选择出来的图形卷积算子 (SP n E ),

图形的值信号 R+γV n 得以在图中有目的性地扩散,并最终获得所选节点的状态-动作值图形信号 Q n+ 1 (S E n ) .这个

操作相当于图卷积的过程,以矩阵相乘的方式执行.通过对 Q n+ 1 (S n E ) 各个通道上的值取最大值,获得所选节点更

新后的状态值V n+ 1 (S n E ). 该操作相当于最大池化的过程.优先级小于阈值的节点在图中被表示为浅灰色方块,且

E

E

它们的状态值V n ( S ν n E ) 不会被更新( ν S 表示 S 的补集).在一轮异步值迭代之后,整个节点空间的状态值 V n+1

n

n

由更新后的节点状态值V n+ 1 (S n E ) 及未更新的节点状态值V n ( S ν n E ) 组成.

R

R+γV n

+ Q n+ 1 (S n E )

n V (S E n )

P (S n E ) 图卷积 X

V n 最大池化

根据函数 f ν(ν;T n)

选择节点

V n+1

V n+ 1 (S E n ) +

非规则图形 G

n V ( S ν n E )

Fig.2 An asynchronous value iteration process in GAVIN

图 2 GAVIN 中的一次异步值迭代过程

2.2 情节式加权双Q学习

与传统 Q 学习算法相比,尽管情节式 Q 学习能够提升规划网络模型的训练稳定性,但在网络参数的更新过

程中,其仍会出现 Q 学习算法中常见的值被过高估计的问题 [22] .与 Q 学习算法相同,情节式 Q 学习在选择最优

动作和计算目标值时使用了相同参数的模型,因此在计算目标值时会给出一个状态-动作值的上限的估计值.由

于模型在训练过程中并不够稳定,该估计值可能存在一些偏差.如果这个偏差不一致,则会造成模型对动作优劣

的判断产生失误,从而影响训练出的模型的性能.为了在保持网络模型的训练稳定性的同时减轻过高估计对训

练性能的影响,本文结合加权双估计器及情节式 Q 学习,提出了情节式加权双 Q 学习算法.