Page 255 - 《软件学报》2021年第8期

P. 255

包希港 等:视觉问答研究综述 2537

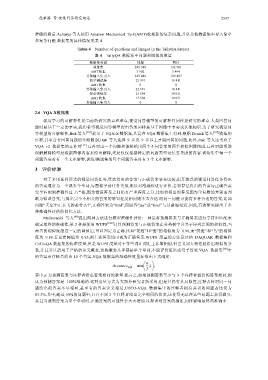

准确的衡量.Acharya 等人使用 Amazon Mechanical Turk(AMT)收集新的复杂问题,并从其他数据集中导入简单

和复杂问题.数据集的具体情况见表 4.

Table 4 Number of questions and images in the TallyQA dataset

表 4 TallyQA 数据集中问题和图像的数量

数据集分割 问题 图片

训练集 249 318 132 981

AMT收集 3 902 3 494

其他输入集引入 245 416 129 487

简单测试集 22 991 18 411

AMT收集 0 0

其他输入集引入 22 991 18 411

复杂训练集 15 598 14 051

AMT收集 15 598 14 051

其他输入集引入 0 0

2.6 VQA-X数据集

深度学习的可解释性是当前的研究热点和难点,视觉问答模型的可解释性同样是研究的难点.人类回答问

题时是基于一定的事实,我们希望视觉问答模型得出答案同样是基于图像中事实或其他知识.为了研究视觉问

答模型的可解释性,Huk 等人 [101] 提出了 VQA-X 数据集,其是在 VQA 数据集上得到.根据 Zitnick 等人 [107] 收集的

注释,其中含有回答问题的年龄限制,Huk 等人选择 9 岁及 9 岁以上才能回答的问题.此外,Huk 等人还考虑了

VQA v2 数据集的互补对 [17] .互补对由一个问题和能够给出两个不同答案的两个相似图像组成.互补对能帮助

理解解释模型是根据图像内容来给出解释,还是仅仅根据特定的问题类型记忆要考虑的内容.训练集中每一个

问题答案对有一个文本解释,训练/测试集的每个问题答案对有 3 个文本解释.

3 评价标准

对于多项选择形式的视觉问答任务,算法得出的答案与正确答案容易比较;但开放式的视觉问答任务得出

的答案通常为一个或多个单词,与图像字幕任务类似,难以对准确性进行评价.若将算法得出的答案与正确答案

完全匹配则准确性过于严格,因为错误答案之间仍有严重程度之分,比如将得出的答案因为单复数的差别而判

断为错误答案,与得出完全不相关的答案的惩罚程度相同则不太合适.而同一问题可能有多种合适的答案,比如

问题“天空中正在飞的是什么?”,正确答案为“bird”,而回答“jay”或“fowl”与其意思相近.因此,有的研究提出了多

种准确性评估的替代方法.

Malinowski 等人 [98] 提出两种方法进行模型准确性评价:一种是将预测答案与正确答案进行字符串匹配来

确定最终的准确性;第 2 种是使用 WUPS [108] 计算预测答案与正确答案在分类树中公共子序列之间的相似性,当

两者的相似度超过一定的阈值后,可以判定为正确.比如“秃鹰”和“鹰”的相似度为 0.96,而“秃鹰”和“鸟”的相似

度为 0.88.若设定阈值为 0.85,则上述答案均可视为正确答案.WUPS 度量的方法是评估 DAQUAR 数据集和

CoCo-QA 数据集的标准度量,但是 WUPS 度量对于某些词在词汇上非常相似,但含义却大相径庭给出相似的分

数,并且其只适用于严格的语义概念,这些概念几乎都是单个单词,不能评价短语或句子答案.VQA 数据集 [78] 中

的答案由注释者给出 10 个答案,VQA 数据集的准确性度量标准由下式确定:

⎛ n ⎞

Accuracy = min ⎜ ,1 ,

⎟

VQA

⎝ 3 ⎠

其中,n 为预测答案与注释者给出答案相同的数量.换言之,如果预测答案至少与 3 个注释者提供的答案相同,则

认为预测答案是 100%准确的.这种度量方式为大部分研究者所采用,但是其仍有其局限性,注释者针对同一问

题给出的答案不尽相同,甚至有的答案含义相反,COCO-VQA 数据集中的注释者拥有共识的问题占比仅为

83.3%.其中,超过 59%的问题中,只有不到 3 个注释者给出完全相同的答案,这使得无法在这些问题上获得满分.

并且当遇到答案为单个单词时,正确答案的可能性会大大增加.注释者对答案的描述,同样影响最终的准确率.