Page 28 - 《软件学报》2021年第6期

P. 28

1602 Journal of Software 软件学报 Vol.32, No.6, June 2021

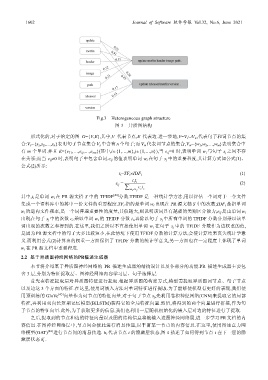

Fig.3 Heterogeneous graph structure

图 3 异质图结构

形式化的,对于给定的图 G={V,E},其中,V 代表节点,E 代表边.进一步地,V=V s ∪V w ,代表句子和词节点的集

合:V s ={s 1 ,s 2 ,…,s n }表明句子节点集合 V s 中含有 n 个句子;而 V w 代表词节点的集合,V w ={w 1 ,w 2 ,…,w m }表明集合中

有 m 个单词.并且 E={e 11 ,…,e ij ,…,e mn }(其中,i∈{1,…,m},j∈{1,…,n}),当 e ij =0 时,表明单词 w i 与句子 s j 之间不存

在关系;而当 e ij ≠0 时,表明句子中包含单词.e ij 的值表明单词 w i 在句子 s j 中的重要程度,其计算方式如公式(1)、

公式(2)所示:

t i =TF i ×IDF i (1)

ct

e = ii (2)

∑ w ∈ j ct

ij

z z

z s

其中,t i 是单词 w i 在 PR 源文档 S 中的 TFIDF [44] 分数.TFIDF 是一种统计学方法,用以评估一个词对于一个文件

集或一个语料库中的其中一份文件的重要程度.TF i 指的是单词 w i 出现在 PR 源文档 S 中的次数;IDF i 是指单词

w i 的逆向文件频率,是一个词普遍重要性的度量,其值越大,则说明该词具有越强的类别区分能力;e ij 是由单词 w i

出现在句子 s j 中的次数 c i 乘以单词 w i 的 TFIDF 分数 t i ,再除以句子 s j 中所有单词的 TFIDF 分数分别乘以该单

词出现的次数之和得到的.在这里,我们之所以不直接使用单词 w i 在句子 s j 中的 TFIDF 分数作为边权重的值,

是因为 PR 源文档中的句子大多比较短小,在此情境下使用 TFIDF 分数的计算方法,会使计算结果丧失统计学意

义.而利用公式(2)计算出的权重一方面保留了 TFIDF 分数的统计学意义,另一方面也在一定程度上体现了单词

w i 在 PR 源文档中重要程度.

2.2 基于异质图神经网络的PR描述生成器

本节将介绍基于异质图神经网络的 PR 描述生成器的结构设计以及各部分的功能.PR 描述生成器主要包

含 3 层,分别为特征提取层、图神经网络内容学习层、句子选择层.

首先在特征提取层对异质图特征进行提取.根据异质图的构建方式,模型需提取异质图词节点、句子节点

以及边这 3 个方面的特征.在这里,使用词嵌入方法对单词特征进行提取.为了能够使模型有更好的表现,我们使

用预训练的 GloVe [45] 向量作为词节点的特征向量.对于句子节点 s j ,先利用卷积神经网络(CNN)来提取它的局部

特征,再利用双向长短期记忆模型(BiLSTM)获得它的全局特征向量.然后,将得到的两个向量进行拼接,作为句

子节点的特征向量.此外,为了获取更多的信息,我们也利用一层随机初始化的嵌入层对边的特征进行了提取.

之后,提取到的节点和边的特征向量以及图的结构信息将被输入进图神经网络层,进一步学习 PR 文档的内

容信息.在图神经网络层中,节点间会彼此进行消息传递,以丰富某一节点的内容信息.在这里,使用图注意力网

络模型(GAT) [46] 进行节点间的消息传递. h i 代表节点 i 的隐藏层状态,图 4 描述了如何得到节点 i 在下一层的隐

藏层状态 h′ .

i