Page 304 - 《软件学报》2021年第5期

P. 304

1528 Journal of Software 软件学报 Vol.32, No.5, May 2021

模型输出非预期的结果,包括黑盒攻击和白盒攻击等多种方式 [13] ;(2) 基于 AI 技术,对网络传输、智能设备、社

交媒体等不同领域进行的入侵行为,例如高级鱼叉式钓鱼攻击、利用 AI 算法破解验证码等 [14] ;(3) 传统的攻击

方式经过推移和演变,呈现出大规模、协同、多阶段的特征,形成趋于自动化和智能化的新一代智能攻击行为 [15] .

与传统的攻击方式相比,智能攻击的隐蔽性更强,危险性更高,因而对系统或网络造成的威胁更大.例如,传

统网络攻击中,攻击规模和攻击效率难以兼顾,而使用 AI 自动执行网络攻击在很大程度上可以兼顾多个方面,

使鱼叉式网络钓鱼、分布式拒绝服务等传统劳动密集型和成本高昂的网络攻击转型并带来更大的威胁;同时,

智能攻击会利用 AI 技术使恶意软件获取对上下文环境的理解,然后通过学习被感染系统的环境信息,尝试尽可

能地将攻击目标的环境融入到攻击中 [16] .

基于以上定义,本节分别挑选 3 种类型中具有代表性的智能攻击作详细阐述.首先是对 AI 系统或模型本身

进行攻击的对抗攻击,攻击者利用“数据投毒”“部署后门”等方式设计恶意对抗样本,干扰 AI 算法的正确输出.然

后介绍基于 AI 技术的智能攻击代表:恶意软件逃逸和智能 APT 攻击,二者均利用 AI 技术训练自身模型,对特定

的用户或系统漏洞发动针对性攻击,例如,恶意软件逃逸通过在良性程序和软件中混淆或隐藏恶意代码片段躲

避防御模型的安全检测,而智能 APT 攻击中典型的钓鱼攻击,通过学习社交网络中用户数据,模拟用户邮件书写

风格、手机操作行为等发起指定性的攻击,却很难被防护系统检测和识别.最后阐述的是由传统攻击方式演变

的自动化僵尸网络的智能攻击,传统僵尸网络随着网络要素的更新和 AI 技术的发展,实现了在攻击过程中自我

学习,进而自动化决策进行繁殖和传播,构成新型的自动化僵尸网络,在以下内容将进行具体阐述.

1.1.1 对抗攻击

智能攻击首先体现在对人工智能系统本身的攻击,攻击者通过设计针对性的数值型向量(numeric vectors)

在原始样本中,干扰机器学习模型的识别和分类,达到其攻击目的.这样的攻击通常称为对抗攻击,攻击样本称

为对抗样本 [17] .具体而言,对抗样本的产生主要因为训练模型的样本集只能覆盖部分,并非包含所有的可能性,

因而不能训练出覆盖全部样本特征的模型,这就导致训练的模型边界与真实决策边界不完全一致,两者之间产

生的差异即为对抗样本的空间.

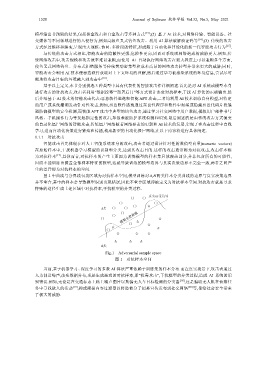

图1中曲线与分界线包裹区域为对抗样本空间,模型训练对 A,B 两类样本分类曲线的边界与真实决策边界

并不重合,其中的样本会导致模型识别出现错误,因此不重合区域即被定义为对抗样本空间.对抗攻击就是寻求

特殊的途径生成上述区域中对抗样本,干扰模型的分类过程.

Fig.1 Adversarial sample space

图 1 对抗样本空间

当前,基于机器学习、深度学习的多数 AI 算法严重依赖于训练集的样本分布.而在真实场景下,攻击者通过

人为制造噪声,改变数据分布,或是生成恶意的对抗样本,即“投毒攻击”,干扰模型的分类过程,造成 AI 系统的识

别错误.例如,无论是在交通标志上贴上噪声图片以欺骗无人车目标检测的分类器 [18] ,还是骗取无人机在侦察任

务中寻找敌人的活动 [19] ,抑或颠覆内容过滤器以将恐怖分子招募宣传发布到社交网络 [20] 等,都给社会安全带来

了极大的威胁.