Page 280 - 《软件学报》2025年第9期

P. 280

陈建炜 等: 基于掩码信息熵迁移的场景文本检测知识蒸馏 4191

指出, 类别平衡的数据集的分布近似于均匀分布且具有最大的信息熵值, 并以此为基础提出了一个新的无数据知

识蒸馏框架 DAFL (data-free learning), 可通过最大化数据集的信息熵, 来促使生成器能够产生类别平衡的合成数

据. Kwon 等人 [39] 提出自适应知识蒸馏 (adaptive knowledge distillation, AKD), 根据教师网络软目标的熵值大小来

决定它的重要性. 其背后原理是信息熵能够衡量教师网络对分类结果的不确定程度, 熵值越大, 其不确定性越高,

分配的权重理应更小.

2 适用于文本检测的信息熵知识

知识蒸馏通过将教师网络 (网络结构复杂的大网络) 的泛化知识迁移到学生网络 (网络层数少的小网络) 来提

高学生网络的泛化能力, 最为关键的地方在于如何定义具有教师网络泛化信息的“知识”. 绝大多数知识蒸馏方法是

为图像分类设计, 而专门针对文本检测模型设计的知识蒸馏方法较少. 基于分割的检测方法能够对图像上每一个像

素点做文本或非文本的二分类, 与图像分类有相通之处, 因此分类的知识蒸馏方法可以直接迁移到文本检测任务

上. 然而, 本文发现有些在图像分类上广泛使用的蒸馏方法 [4,8] 在较大数据集上普遍效果不佳, 其原因是这些蒸馏方

法以图像分类的方式提取文本检测模型的知识, 缺乏足够的泛化信息. 针对软目标知识存在泛化信息不足的问题,

本文定义了一种更具有泛化性的信息熵知识, 和教师网络的软目标知识同时使用, 有效提升学生网络的精度.

信息熵知识的灵感来源于教师网络和学生网络输出的分割图 (segmentation map) 的视觉混乱程度的对比, 分

割图上每一个像素点的值代表属于文本的概率值. 教师网络泛化能力强, 预测更加准确 [40] , 因此误判的情况少, 表

现在一些模糊的噪声区域 (图 2(a) 和 (b) 中红色虚线标识区域) 中文本的概率接近 0, 而学生网络的分割图在一些

噪声区域有较高的概率值, 整体看起来更加混乱. 在知识蒸馏的概念中知识是体现教师网络泛化能力强的信息, 而

分割图的混乱程度可以反映预测能力的强弱, 直接与泛化能力相关联. 因此, 可以尝试从分割图混乱程度中挖掘泛

化信息 [40] , 本文将分割图看作是由图上所有像素点组成的一个系统, 每个像素点的概率分布满足文本或非文本的

0-1 分布, 视觉上看到的混乱实质是整个系统的不确定性, 而信息熵可以表示系统的不确定性. 本文进一步从信息

熵角度分析输出的分割图, 发现信息熵蕴含了模型对文本边缘的关注信息.

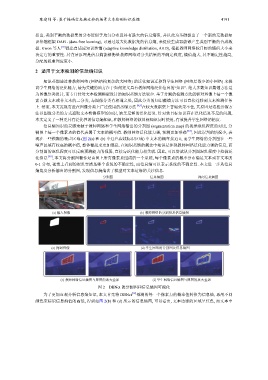

分割图 信息熵图 掩码信息熵图

(a) 输入图像 (b) 教师网络的分割图及信息熵图

(c) 掩码图像 (d) 学生网络的分割图及信息熵图

(e) 教师网络信息熵图与原图的放大叠加 (f) 学生网络信息熵图与原图的放大叠加

图 2 DBNet 的分割图和信息熵图可视化

为了更加直观分析信息熵知识, 本文首先将 DBNet [12] 预测的每一个像素点的概率值转换为信息熵, 再用不同

颜色来标识信息熵值的高低, 得到如图 2(b) 和 (d) 所示的信息熵图, 可以看出, 文本边缘的区域呈红色, 而文本中