Page 206 - 《软件学报》2025年第9期

P. 206

王鑫澳 等: 基于联邦学习的 BERT 模型高效训练框架 4117

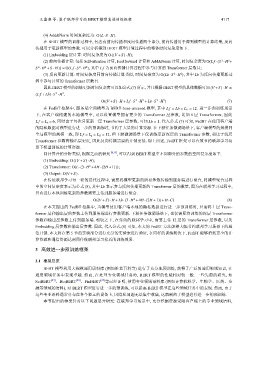

(4) Add&Norm 时间复杂度为: O(L·S · H).

在 BERT 模型的训练过程中, 包含有前向传播和反向传播两个部分, 前向传播用于得到模型的计算结果, 反向

传播用于更新模型的参数. 可以分析得到 BERT 模型计算过程中的整体时间复杂度如下.

(1) Embedding 层计算: 时间复杂度为 O((V +S )· H);

(2) 前向传播计算: 包括 Self-attention 计算, feed forward 计算和 Add&Norm 计算, 时间复杂度为 O(L f ·(S · H +

2

2

2 2 2 2 L f 为前向传播计算过程中参与计算的 Transformer 层数目;

S · H +S · H )) ≈ O(L f ·S · H ), 其中

2 2 Lb 为反向传播更新过

(3) 反向更新计算: 时间复杂度同前向传播计算类似, 时间复杂度为 O(Lb·S · H ), 其中

程中参与计算的 Transformer 层数目.

因此 BERT 模型的训练更新时间复杂度可以如公式 (7) 所示, 并且根据 BERT 模型的具体数据可知 (V +S )· H ≪

2

2

(L f + Lb)·S · H .

2

2

2

2

O((V +S )· H + L f ·S · H + Lb·S · H ) (7)

在 FedBT 框架中, 服务端全局模型为 BERT-base-uncased 模型, 其中 L f = Lb = L G = 12. 进一步预训练场景

下, 在客户端构建的本地模型中, 可以设置模型拥有更少的 Transformer 层参数, 比如 6 层 Transformer, 因此

L f = L k = 6, 同时由于每次只更新一层 Transformer 层参数, 可知 Lb = 1. 代入公式 (7) 可知, FedBT 在使用客户端

的隐私数据对模型进行进一步的预训练时, 节约了大量的计算资源. 在下游任务微调场景下, 客户端模型的规模同

L f = L = L G = 12. 但下游微调场景下仅训练更新深层的 Transformer 参数, 相比于浅层

全局模型的规模一致, 即 k

Transformer 参数离输出层更近, 因此反向传播需要的开销更低. 综上所述, FedBT 框架可以有效节约联邦学习场

景下模型训练的计算资源.

同计算开销分析类似, 根据之前的研究 [8,13] , 可以得到 BERT 模型中不同部分的参数的空间复杂度如下.

(1) Embedding: O((V +S )· H);

(2) Transformer: O(L·(3· H +4H ·(2H +1)));

2

(3) Output: O(V +S ).

在传统联邦学习每一轮的迭代过程中, 需要将模型更新的所有参数传输到服务端进行聚合, 将模型聚合过程

中的空间复杂度表示为公式 (8), 其中 Lb 表示参与反向传播更新的 Transformer 层的数量, 因为在联邦学习过程中,

只有进行本地训练更新的参数需要上传到服务端进行聚合.

2

O((V +S )· H + Lb·(3· H +4H ·(2H +1))+ H ·C) (8)

在本文提出的 FedBT 框架中, 当模型使用客户端本地的隐私数据进行进一步预训练时, 只需将 1 层 Trans-

former 层和输出层的参数上传到服务端进行参数更新. 下游任务微调场景下, 也仅需要将训练的深层 Transformer

参数和输出层参数上传到服务端. 相较之下, 在传统的联邦学习中, 需要上传 12 层的 Transformer 层参数, 以及

Embedding 层参数和输出层参数. 因此, 代入公式 (8) 可知, 本文的 FedBT 方法能够大幅节约联邦学习场景下的通

信开销. 本文将在第 5 节的实验部分进行充分的实验来进行验证, 在同样的训练轮次下, FedBT 能够消耗更少的计

算资源和通信资源达到同传统联邦学习接近的训练效果.

3 高效进一步预训练框架

3.1 框架总览

BERT 模型利用大规模通用语料库 (例如维基百科等) 进行了充分地预训练, 获得了广泛的通用领域知识, 在

通用领域任务中表现卓越. 然而, 在处理专业领域任务时, BERT 模型的性能相对较一般. 一些先前的研究, 如

SciBERT [27] 、BioBERT [28] 、FinBERT [29] 等已经证明, 使用专业领域语料库 (例如计算机科学、生物学、医药、金

融等领域的语料), 对 BERT 模型进行进一步的预训练, 可以提高 BERT 模型在这些领域任务中的表现. 然而, 由于

这些专业语料通常分布在各个独立的设备上, 因隐私问题无法集中收集, 这就制约了模型进行进一步的预训练.

本节提出的框架针对以下问题展开研究: 在联邦学习场景中, 充分挖掘资源受限客户端上的专业领域语料,