Page 368 - 《软件学报》2025年第7期

P. 368

高梦楠 等: 面向深度学习的后门攻击及防御研究综述 3289

整体上, 计算机视觉领域和自然语言处理领域后门防御思路一致. 基于输入的防御利用中毒样本与干净样本

在特征空间与模型训练中的差异, 在模型部署前与运行时拦截可疑后门样本. 基于模型的后门防御通过干净模型

与后门模型在样本上的行为差异拦截可疑模型. 基于输入的后门防御以检测后门样本为主, 对于识别出的后门样

本, 直接删除后门样本或是通过生成网络修复后门样本.

由于计算机视觉与自然语言处理数据在嵌入空间的差异, 其后门防御方法在实现细节上存在不同. 计算机视

觉中的防御方法需要修改后才能应用在自然语言处理任务上, 比如 STRIP 在图像上添加随机扰动, 而在文本上添

加的是 token.

目前, 计算机视觉和自然语言处理领域的后门防御方法存在缺乏可证明安全、泛化能力较差、防御效率较低

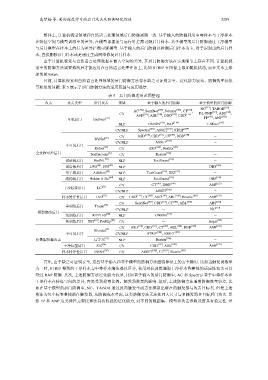

等相似的问题. 表 5 展示了后门防御方法的适用范围与应用场景.

表 5 后门防御适用范围整理

攻击 攻击类型 后门攻击 领域 基于输入的后门防御 基于模型的后门防御

AC [100] , SentiNet [105] , Februus [106] , CT [107] , NC [117] , TABOR [118] ,

[120]

[119]

CV [110] [108] [109] [111] DL-TND , ABS ,

ASD , ABL , DBD , CBD [121] [122]

可见后门 BadNets [21] FP , ANP

NLP ONION [112] , RAP [114] T-Miner [125]

CV/NLP Spectral [101] , ASSET [102] , STRIP [104] -

CV ASD [110] , CBD [111] , CT [107] , DBD [109] -

WaNet [26]

CV/NLP ASSET [102] -

不可见后门

Refool [23] CV ASD [110] , Beatrix [103] -

全过程可控后门 BadEncoder [31] CV Beatrix [103] -

词语级后门 BadNL [39] NLP TextGuard [116] -

词语级后门 LWS [40] , SOS [43] NLP - DBS [126]

句子级后门 AddSent [42] NLP TextGuard [116] , BKI [113] -

结构级后门 Hidden Killer [44] NLP TextGuard [116] DBS [126]

CV CT [107] , DBD [109] ANP [122]

干净标签后门 LC [52]

CV/NLP ASSET [102] -

样本特异性后门 IAD [67] CV CBD [111] , CT [107] , ASD [110] , ABL [108] , Beatrix [103] ANP [122]

CV SentiNet [105] , CBD [111] , CT [107] , ABL [108] ABS [120]

重训练后门 Trojan [72]

CV/NLP - NC [117]

模型修改后门

免训练后门 RIPPLES [80] NLP ONION [112] -

免训练后门 TBT [83] , ProFlip [84] CV - Aegis [129]

[110] [111] [107] [108] [109] [122]

CV ASD , CBD , CT , ABL , DBD ANP

Blended [2]

不可见后门 CV/NLP STRIP [104] , ASSET [102] -

仅数据投毒攻击 Li等人 [91] NLP Beatrix [103] -

干净标签后门 SIG [94] CV CBD [111] , ABL [108] ANP [122]

样本特异性后门 ISSBA [98] CV ASSET [102] , CT [107] , Beatrix [103] -

首先, 由于缺乏可证明安全, 这些基于输入和基于模型的防御方法面临算法上的安全隐患. 比如当触发词数量

为一时, STRIP 得到的干净样本与中毒样本熵值难以区分, 使用对抗训练增强干净样本鲁棒性的适应性攻击可以

绕过 RAP 防御. 其次, 上述防御方法泛化能力较差, 比如基于输入的后门防御中, AC 和 Spectral 基于中毒样本和

干净样本在特征空间的差异, 容易受到投毒比例、触发器数量的影响. 最后, 上述防御方法通常防御效率较差, 比

如在基于模型的后门防御中, NC、TABOR 通过反向触发生成方法模拟出潜在的触发器与攻击目标类. 但是上述

算法为每个标签重构潜在触发器, 从防御成本考虑, 这类防御方法无法处理大尺寸与多触发器多目标后门攻击. 虽

然 FP 和 ANP 这类神经元剪枝算法具有较强的泛化能力, 对不同的数据集、模型和攻击参数设置具有稳定性. 但