Page 65 - 《软件学报》2025年第5期

P. 65

胡强 等: 融合潜在联合词与异质关联兼容的 Web API 推荐 1965

(4) 多样性 (indra-list similarity, ILS): ILS 用于评价 Web API 推荐列表的多样性, 如公式 (36) 所示:

2 ∑ ∑ ( )

ILS (R) = sim s i , s j (36)

N (N −1)

s i ∈R s j ∈R,i,j

其中, R 表示 Web API 推荐列表, N 为 R 中的服务数量, sim(s i , s j ) 为度量 s i 与 s j 相似度的余弦相似度函数. ILS 值

越小, 推荐列表的多样性越好.

4.3 实验结果与分析

数据集中 Mashup 服务 Web API 平均调用数量为 2.8, 因此选取 Top-3、Top-5 和 Top-7 这 3 种长度的推荐结

果进行验证. 在结果展示中, 表格中的加粗数据为对比指标的最优值.

4.3.1 SY-SimCSE 的服务功能向量生成质量评估

选取 LDA [34] 、RoBERTa [35] 、GSDMM [36] 和 SimCSE [29] 作为对比模型, 其中 LDA 与 GSDMM 为主题模型,

RoBERTa 和 SimCSE 是以 BERT 为基础改进的神经网络模型. 在 Y-SimCSE 方法中, 采用原始 YAKE 模型提取

功能特征词. 通过不同模型为 Mashup 服务需求和 Web API 的服务描述生成功能向量, 进行相似度匹配实现 Web

API 推荐, 各评价指标参见表 2.

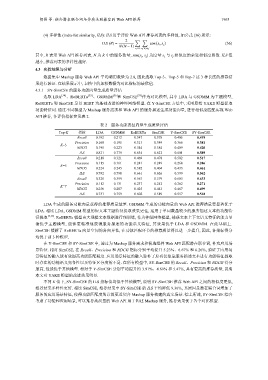

表 2 服务功能表征向量生成质量评估

Top-K 指标 LDA GSDMM RoBERTa SimCSE Y-SimCSE SY-SimCSE

Recall 0.192 0.212 0.347 0.378 0.405 0.419

Precision 0.168 0.195 0.313 0.349 0.366 0.381

K=3

NDCG 0.198 0.223 0.344 0.384 0.409 0.420

ILS 0.821 0.779 0.634 0.622 0.601 0.589

Recall 0.218 0.321 0.469 0.478 0.502 0.517

Precision 0.115 0.161 0.241 0.249 0.268 0.286

K=5

NDCG 0.224 0.245 0.382 0.404 0.433 0.461

ILS 0.792 0.798 0.661 0.626 0.599 0.562

Recall 0.328 0.399 0.561 0.579 0.603 0.633

Precision 0.112 0.131 0.237 0.242 0.262 0.271

K=7

NDCG 0.256 0.287 0.425 0.443 0.467 0.499

ILS 0.731 0.759 0.602 0.589 0.557 0.518

LDA 生成的服务功能向量获得的推荐质量最差. GSDMM 生成的功能向量的 Web API 推荐质量要显著优于

LDA. 相比 LDA, GSDMM 模型的短文本主题特征提取效果更佳, 适用于单词数量较少的服务描述文本的功能特

征提取 [4,32] . RoBERTa 模型由大规模文本数据进行预训练, 作为神经网络模型, 捕获文本上下文语义特征的能力显

著优于主题模型, 能够更精准地获得服务描述的功能语义特征, 其效果优于 LDA 和 GSDMM. 在此基础上.

SimCSE 缓解了 RoBERTa 向量空间的各向异性, 在功能匹配环节的推荐质量得以进一步提升, 因此, 各指标得分

均优于前 3 种模型.

在 Y-SimCSE 和 SY-SimCSE 中, 通过为 Mashup 服务需求和候选组件 Web API 匹配潜在联合词, 补充应用场

景特征. 相对 SimCSE, 在 Recall、Precision 和 NDCG 指标分别平均提升 5.23%、6.67% 和 6.26%, 验证了应用场

景特征的融入能有效提高功能匹配精度. 应用场景特征的融入弥补了原有仅依靠服务描述文本进行功能特征提取

时存在的功能语义完备性以及特征区分度的不足. 在所有模型中, SY-SimCSE 的 Recall、Precision 和 NDCG 得分

最高, 性能优于其他模型. 相对于 Y-SimCSE 分别平均提升约 3.91%、4.69% 和 5.47%, 具有更高的推荐质量, 说明

本文对 YAKE 模型的改进效果明显.

不同 K 值下, SY-SimCSE 的 ILS 指标值均低于其他模型, 说明 SY-SimCSE 推荐 Web API 之间的相似度更低,

推荐结果多样性更好. 相比 SimCSE, 推荐结果中 SY-SimCSE 的 ILS 平均降低 9.36%, 其原因是潜在联合词增加了

服务的应用场景特征, 使得功能匹配度的计算更近契合 Mashup 服务构建的真实场景. 综上所述, SY-SimCSE 综合

考虑了功能和应用场景, 可以推荐高质量的 Web API 用于构建 Mashup 服务, 推荐效果优于各个对比模型.