Page 171 - 《软件学报》2025年第4期

P. 171

杨紫超 等: 基于性能建模的深度学习训练任务调度综述 1577

相较之下, 中小规模集群的任务在时序方面规律较弱, 因此针对这类集群的工作更关注从任务资源使用特征

挖掘元信息. Harmony [44] 针对 PS 架构下分布式任务之间的通信干扰, 基于强化学习方法建模. 该方法利用历史数

据拟合多层感知机模型, 将任务的参数服务器数量、计算节点数量作为元信息特征, 将吞吐率作为预测目标. 随

后, 将吞吐率预测模型作为任务放置的奖励函数, 通过在线上运行收集数据, 不断训练强化学习策略, 反馈式地调

节吞吐率预测模型. 与前述方法不同, GENIE [46] 针对不同放置拓扑的通信开销进行细化分析, 将分布式任务训练拆

解为计算与同步通讯的两个过程, 随后分别为每个过程建立回归模型, 通过收集大量离线任务的放置拓扑, 以及

GPU 占用量, 通信资源占用量等元信息, 来拟合不定系数, 从而在线上为其他任务进行建模. 以上这些不依赖时序

规律的方法对适用的集群没有要求, 然而由于仅从资源视角提取特征, 难以对任务内部的变化进行感知, 因此面对

多样化的任务时处于劣势.

尽管这类方法对解决资源配置多样性存在优势, 但这类方法主要从元信息视角提取任务特征, 并不关心深度

学习模型的内部结构. 这导致在面对未见过的新模型结构时泛化性能较差, 因此在应对任务多样性挑战时存在困难.

2.4 基于计算图结构的方法

表 3 展示了基于计算图结构的任务性能建模方法. 深度学习模型实质上是由算子构成的有向无环计算图, 因

算图特征, 该数据结构大幅压缩了特征空间. 随后, 该方法利用

此这类方法端到端地从计算图整体结构中提取特征, 并直接利用这些特征构建学习模型来预测性能指标.

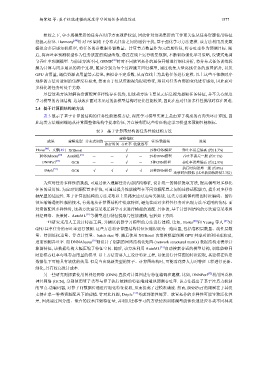

表 3 基于计算图结构的任务性能建模方法

建模指标

成果 建模选型 分布式训练 任务/数据集 效果

执行时间 吞吐率 收敛效率

Horus [48] 、文献[49] XGBoost - - √ - 19种CNN模型 吞吐率误差偏高 (约11.3%)

[50] [51]

DNNAbacus AutoML - - √ - 29种DNN模型 吞吐率误差一般 (约7.1%)

DNNPerf [52] GCN - - √ - 5种CNN模型 吞吐率误差偏高 (约12.8%)

执行时间误差一般 (约8%)

[53]

Driple GCN √ √ √ √ 10种DNN模型

迁移时间较低 (比重新训练降低7.3倍)

为应对任务多样性的挑战, 可通过深入理解任务内部结构特征, 设计统一的特征提取方法, 提高模型对多样化

任务的适用性. 为应对资源配置多样性, 可通过提升性能模型在不同资源配置之间的迁移适配能力, 提升对多样资

源配置的适应性. 基于计算图结构的方法采取以上思路来应对这两类挑战. 这类方法能够利用图特征编码、图特

征压缩等通用性强的技术, 有效地从计算图结构中提取特征, 避免在面对多样性任务时出现方法不适用的情况. 面

对资源配置多样性时, 这类方法通常采取迁移学习来进行模型的适配. 具体的, 基于计算图结构的方法通常采取图

神经网络、决策树、AutoML [51] 等模型进行特征提取与性能建模, 包括如下方面.

一些研究采用人工设计特征工程, 并辅以机器学习模型的方法进行建模. 比如, Horus [48] 和 Yeung 等人 [49] 对

GPU 共享任务的吞吐率进行预测. 这些方法将计算图结构特征压缩提取为一维向量, 包括卷积层数量、线性层数

量、待训练权重量、浮点计算量、batch size 等. 随后使用 XGBoost 决策树模型预测 GPU 共享时的利用率波动,

进而预测吞吐率. 而 DNNAbacus [50] 则设计了创新的网络结构化矩阵 (network structural matrix) 数据结构来表示计

AutoML [51] 自动搜索合适的模型结构, 训练能够同

时建模吞吐率与显存占用量的模型. 以上方法需要人工设计特征工程, 以便进行计算图的特征提取, 其建模在特定

数据集下可能具有较优的效果. 但是当出现新类型的算子、计算图结构时, 可能需花费人力对特征工程进行更新、

细化, 具有较高设计成本.

另一些研究则探索使用图神经网络 (GNN) 直接对计算图进行特征编码和建模. 比如, DNNPerf [52] 利用图卷积

神经网络 (GCN), 分别使用算子类型与算子执行依赖的特征端到端地预测吞吐率. 该方法提出了基于注意力机制

的节点-边编码器, 对算子间数据传递进行细化特征提取, 从而提高了建模准确度. 然而, DNNPerf 的限制在于其仅

支持在单一种类资源配置下的建模. 针对此问题, Driple [53] 考虑到弹性部署、放置拓扑的多样性可能导致泛化性

差, 因此通过图分组、聚合的技术压缩特征量, 并利用迁移学习的方法使预训练模型能够快速适应各类不同种类