Page 312 - 《软件学报》2020年第11期

P. 312

李娜 等:一种基于卷积神经网络的砂岩显微图像特征表示方法 3627

网络训练时具有更快的收敛速度,且不存在梯度饱和问题.因此,FeRNet 网络卷积层均采用 ReLu 函数作为激活

函数,其定义为

ReLu(x)=max(0,x).

(3) 最大池化层

为降低数据的特征维度,防止参数过拟合,在每两个卷积层之后加入一个最大池化层对特征图进行下采样.

最大池化层的卷积核(过滤器)采用 2×2 大小,步长设为 1.每次对特征图进行最大池化操作后,输出特征图变为输

入大小的 1/2.

(4) 全连接层

全连接层的目的是将卷积层和池化层输出的特征图映射至样本标记空间.FeRNet 共包含 3 个全连接层.前

两个全连接层使用 ReLu 作为激活函数,输出维度分别为 1 024 和 256.最后一个全连接层为 FeRNet 网络的输出

层,属于分类层,采用 Softmax [37] 作为激活函数,其定义为

e j x

Softmax () x = N ,

∑ n= 1 e n x

其中,N 为输出神经元的数目.本文中 N=3,对应于 3 种砂岩显微图像类型,即长石砂岩、岩屑砂岩和石英砂岩.

(5) Dropout 层

为了进一步防止参数过拟合,在前两个全连接层之后各增加一个 Dropout 层 [24] ,在训练过程中更新参数时

以 50%的概率随机断开输入神经元.

FeRNet 网络的目标是对砂岩显微图像进行特征表示,提取其语义信息.因此在网络训练过程中,所有网络

层均参与网络参数的训练;在特征提取阶段,则丢弃 Dropout_2 和 Fc_3 层,将第 2 个全连接层 Fc_2 作为特征提

取器,取其输出作为砂岩显微图像的特征表示.因此,本文共提取 256 维语义特征来描述砂岩显微图像.

2.3.2 FeRNet 网络训练

如前所述,带标记砂岩显微图像数量不足可能会削弱砂岩显微图像的预测准确性.针对此问题,上文分别从

图像扩增和 FeRNet 网络结构两个方面提出解决方案.本节将从 FeRNet 网络训练的角度进行优化.在 FeRNet

网络训练之前,预先训练一个卷积自编码网络 [39] (简称 FeRCAE),用于初始化 FeRNet 网络的权重,强化 FeRNet

网络的学习.FeRCAE 网络的详细设置在表 2 中列出.

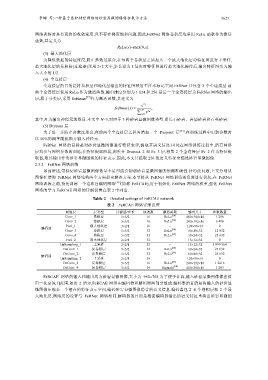

Table 2 Detailed settings of FeRCAE network

表 2 FeRCAE 网络详细设置

网络层 层类型 过滤器/步长 通道数 激活函数 输出尺寸 参数数量

Conv_1 卷积层 5×5/2 16 ReLu [24] 480×384×16 1 216

Conv_2 卷积层 5×5/2 16 ReLu [24] 240×192×16 6 416

Pool_1 最大池化层 2×2/1 16 − 120×96×16 0

编码器 [24]

Conv_3 卷积层 5×5/2 32 ReLu 60×48×32 12 832

Conv_4 卷积层 5×5/2 32 ReLu [24] 30×24×32 25 632

Pool_2 最大池化层 2×2/1 32 − 15×12×32 0

UpSampling_1 上采样 2×2/1 32 − 15×12×32 5 899 864

DeConv_1 反卷积层 5×5/2 32 ReLu [24] 30×24×32 25 632

DeConv_2 反卷积层 5×5/2 32 ReLu [24] 60×48×32 25 632

解码器

UpSampling_2 上采样 2×2/1 16 − 120×96×16 0

DeConv_3 反卷积层 5×5/2 16 ReLu [24] 240×192×16 1 2816

DeConv_4 反卷积层 5×5/2 16 Sigmoid [38] 480×384×16 1 203

FeRCAE 网络的输入和输出均为砂岩显微图像,大小为 960×768.为了便于计算,输入砂岩显微图像像素值

归一化至[0,1]范围.如表 2 所示,FeRCAE 网络由编码器和解码器两部分组成.编码器的目的是将输入的砂岩显

微图像压缩至一个潜在的特征表示空间,编码砂岩显微图像隐含的语义信息.编码器包含 4 个卷积层和 2 个最

大池化层,网络层的设置与 FeRNet 网络相同.解码器的目的是根据编码器输出的语义特征重构出砂岩显微图